2017年底,麻省理工学院(MIT)旗下知名科技媒体《技术评论》(MIT Technology Review)发布了对2018年网络安全形势的权威预测报告,其中特别强调了六大类型的网络威胁将日益凸显。值得注意的是,报告不仅关注了传统的攻击手段,更将目光投向了新兴技术领域,明确指出人工智能(AI)基础软件的安全开发将成为影响未来网络生态安全的关键一环。

报告所列举的六大威胁类型,反映了网络攻击正在向更复杂、更隐蔽、破坏性更大的方向演进:

- 供应链攻击的规模化:攻击者不再局限于直接攻击最终目标,而是转而入侵软件供应商、开源库或硬件制造环节,通过污染合法软件更新或组件,实现“一点突破,全网受害”的效应。2017年的NotPetya勒索软件事件已敲响警钟。

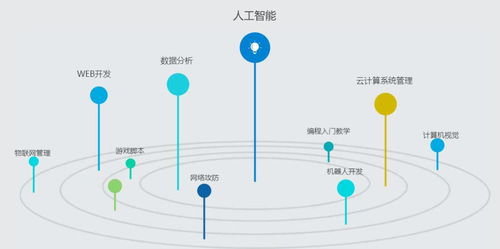

- 物联网(IoT)僵尸网络的持续进化:随着联网设备数量激增且安全性普遍薄弱,由摄像头、路由器等设备组成的僵尸网络将更加庞大和智能化,足以发动前所未有的分布式拒绝服务(DDoS)攻击,甚至成为其他攻击的跳板。

- 针对关键基础设施的定向攻击:能源、水利、交通、金融等国家关键信息基础设施面临更高精度的网络攻击威胁,攻击可能兼具物理破坏与网络瘫痪的双重目的,地缘政治因素使其风险加剧。

- 利用人工智能发起的自动化攻击:AI技术开始被攻击者用于自动化漏洞挖掘、生成高度逼真的钓鱼内容(如深度伪造语音、视频)、或自适应地绕过安全检测系统,使攻击速度与精准度大幅提升。

- 数据操纵与污染攻击:攻击目标从简单的数据窃取或加密勒索,转向更阴险的数据篡改。通过污染训练数据(“数据投毒”)来破坏AI系统的决策,或悄悄修改财务、医疗、科研等关键数据,其长期破坏性可能远超数据泄露。

- 云服务与混合环境的安全挑战:企业大规模向云端和混合IT架构迁移,配置错误、权限管理复杂化以及跨环境的数据流动,使得攻击面急剧扩大,传统的边界防御模型难以应对。

在深入分析这些威胁时,《技术评论》报告特别点出了一个根本性的、且影响深远的议题:人工智能基础软件开发的安全隐患。这不仅是上述第四、第五类威胁的直接成因,也与其他威胁类型息息相关。

为何AI基础软件安全成为核心关切?

AI基础软件,包括主流的机器学习框架(如TensorFlow、PyTorch)、算法库、开发工具链以及预训练模型,正成为数字经济的新“操作系统”。其开发过程普遍存在以下安全短板:

- 开发社区重功能、轻安全:AI开发社区文化以快速迭代、追求模型性能(如准确率、速度)为主导,安全编码实践、漏洞管理流程往往被忽视。许多基础库由学术研究项目演化而来,并未经过严格的企业级安全开发周期(如SDL)。

- 复杂依赖与“黑盒”特性:AI软件栈依赖关系极其复杂,包含大量第三方开源组件。深度学习模型本身具有“黑盒”特性,其内部决策逻辑难以解释,这使得发现其中潜在的后门、偏见或被植入的恶意逻辑变得异常困难。

- 数据与模型的一体化风险:AI系统安全是数据安全、模型安全和代码安全的综合体。攻击者可通过污染训练数据集(数据投毒),或在模型发布渠道植入恶意模型,从而在源头埋下隐患。而当前的安全工具和标准主要针对传统软件,缺乏对AI模型完整性和可信度的有效验证手段。

- 人才缺口与意识不足:兼具顶尖AI技术和深厚安全攻防知识的复合型人才极度稀缺。大多数AI开发者对潜在的安全威胁认识不足,未能将安全思维融入模型设计、数据准备和部署运维的全过程。

应对之道:构建安全可信的AI开发生态

针对这一预测,《技术评论》也隐含地指出了应对方向。要化解因AI基础软件引发的网络威胁,需要业界协同努力:

- 将安全前置到AI开发生命周期:借鉴DevSecOps理念,形成“AI SecOps”。在框架设计、算法选择、数据收集清洗、模型训练、测试验证及部署上线的每一个环节,都需融入安全考量和自动化安全检查。

- 推动标准、工具与最佳实践:亟需制定针对AI软件的安全开发标准、模型健壮性测试基准,并开发专用的安全工具,用于检测数据投毒、对抗样本、模型后门以及依赖组件的已知漏洞。

- 加强开源生态治理:对关键的AI开源项目,建立更严格的安全审查和托管机制,鼓励安全贡献和漏洞奖励计划,提升核心基础设施的软件物料清单(SBOM)透明度和可追溯性。

- 投资于教育与研究:大力培养AI安全专业人才,同时支持基础研究,探索可解释AI(XAI)、联邦学习、隐私计算等技术,从根本上增强AI系统的透明性、鲁棒性和隐私保护能力。

麻省理工学院《技术评论》的这份预测,精准地捕捉了网络威胁与前沿技术深度融合的趋势。它警示我们,在享受人工智能带来的巨大红利时,必须正视其基础软件层所潜藏的系统性风险。2018年及以后,网络安全的战场已不再局限于传统的系统和应用,更延伸至算法、数据和塑造智能世界的底层代码之中。确保AI基础软件开发的安全与可信,不仅是技术挑战,更是保障未来数字社会稳健运行的基石。